La herramienta conversacional ChatGPT impulsó una revolución de la inteligencia artificial; sin embargo, también provocó advertencias de especialistas de que estos programas podrían inundar Internet de desinformación e influir en la decisión de los votantes.

OpenAI, la firma estadounidense que está detrás del robot virtual de ChatGPT anunció que lanzará herramientas en contra de la desinformación, en este año en el que se celebran docenas de elecciones en países a escala mundial.

La herramienta conversacional ChatGPT impulsó una revolución de la inteligencia artificial; sin embargo, también provocó advertencias de especialistas de que estos programas podrían inundar Internet de desinformación e influir en la decisión de los votantes.

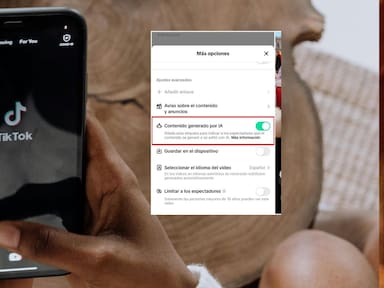

Este 2024, se estarían celebrando numerosas elecciones a escala global, en países que van desde Estados Unidos, India e incluso Gran Bretaña o México, por lo que OpenAI declaró el lunes que no permitirá que su tecnología, que incluye a ChatGPT y el generador de imágenes de Dall-E sean utilizados en campañas políticas.

Ante esto, en una entrada de su blog oficial, OpenAI aseguró que buscan que su tecnología “no se use para socavar procesos democráticos”.

De momento, aún trabajan para comprender la eficacia de las herramientas para la persuasión personalizada; y, hasta el momento, no permitirán construir aplicaciones para campañas políticas.

La IA: un peligro en desinformación electoral.

Es menester señalar que la inteligencia artificial podría traer un impacto significativo en cuanto a la desinformación de las personas, siendo uno de los mayores riesgos mundiales a corto plazo y que podría generar perjuicios para gobiernos recién elegidos en las principales potencias económicas.

De acuerdo con los expertos, el temor a la desinformación electoral comenzó hace ya años; pero, ahora, con los generadores de texto e imágenes basados en inteligencia artificial, esta amenaza se ha visto incrementada. Especialmente al observar que los usuarios no podrían distinguir fácilmente si el contenido es falso o manipulado.

La coalición, también conocida como C2PA (Coalition for Content Provenance and Authenticty” (Coalición para la autenticidad y procedencia de los contenidos), pretende mejorar la identificación y rastreo de contenidos digitales.